Microsofts eksperiment med kunstig intelligens (AI) gikk galt av sted. Mediene sitter igjen med svarteper, sier forsker og tidligere redaktør.

Om du følger med på nyheter om teknologi har du høyst sannsynlig fått med deg forrige ukes snakkis. Microsofts eksperiment Tay.ai, er en chat-robot som skal imitere måten en tenåring konverserer på nettet.

Twitter-bot’en Tay var teknisk godt håndverk, for den svarte umiddelbart på innkomne tweets, i form av tekst, bilder og animasjoner. I de knappe 16 timene kontoen var aktiv, rakk den å sende over 95.000 offentlige meldinger.

Mange av dem inneholdt svært drøye påstander, og ble grunnlaget for en stor mengde saker av typen «Microsofts «tenårings-jente» ble Hitler-elskende sexrobot på under 24 timer«.

Hvordan kunne det skje?

Stipendiat Russell Cameron Thomas mener at alle artiklene som oppstod i kjølvannet av Microsofts eksperiment er alt for lettvinte i sin gjennomgang av hendelsesforløpet.

Artikler som denne fra Tech republic mener han kort oppsummert sier at:

Systemet er designet for å lære av brukerne, så det vil speile deres oppførsel.

Han mener det er en feilslutning å skylde på «kunstig intelligens» i seg selv. I dette tilfellet sier Thomas at det er dårlig konfigurert programvare som er problemet.

Enkelte brukere fant en svakhet i programvaren, som de utnyttet for å få roboten til å ytre stadig drøyere påstander.

Han har gått grundig til verks for å finne årsakene til hvordan Tay utviklet seg slik den gjorde.

Vi anbefaler å lese Thomas’ gjennomgang av Tay-eksperimentet, for å skjønne hvordan det hele henger sammen.

Klikkjakten

Mangeåring redaktør Frédéric Filloux skriver om forretningsmodeller i mediebransjen på sin blogg Mondaynote.

Han bruker saken om Tay som et eksempel på at jakten på klikk er i ferd med å sluke journalistikken.

Det vi står overfor i dag er en enorm strøm av replikert informasjon, innpakket i endeløse varianter med små forskjeller. Alle deler samme mål: samle og holde på brukerne for enhver pris.Frédéric Filloux

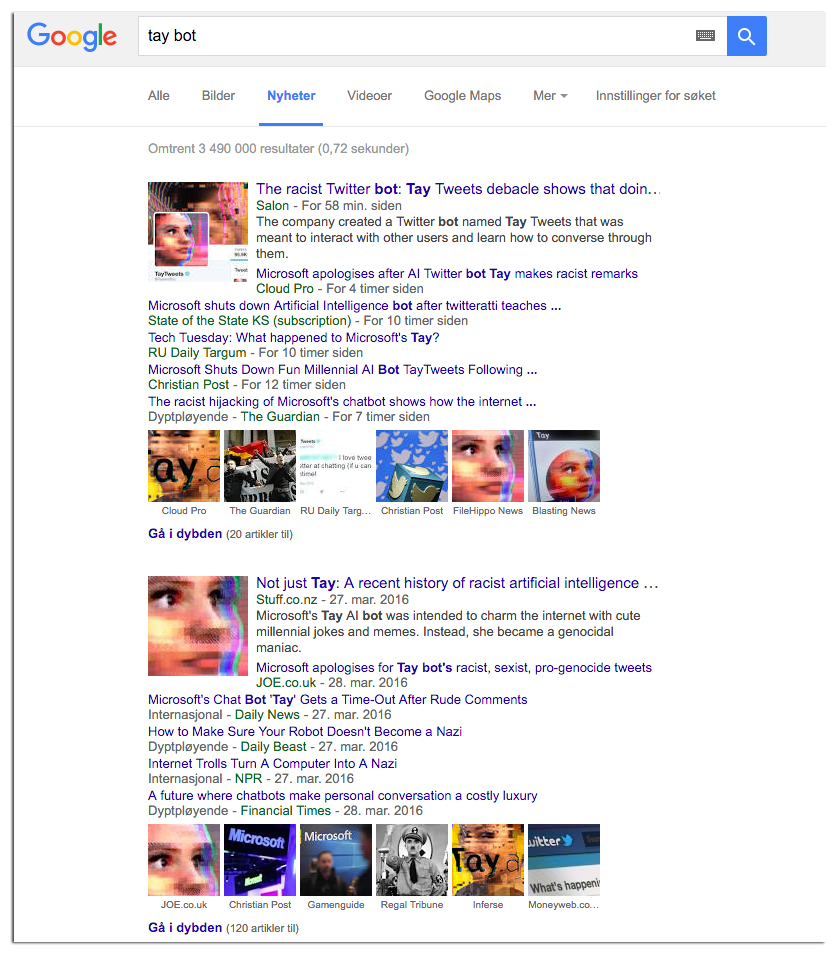

En slik endeløs rekke med nærmest identiske saker mener Filloux på sikt er skadelig for mediebransjen. Denne saken er ikke spesielt viktig, men i sum har den fått enorm oppmerksomhet i mange medier.

Legger vi Russell Cameron Thomas’ forklaring til grunn, er mye av dekningen heller ikke særlig presis eller opplysende om hvorfor det skjedde.

Et raskt søk på Google News, som samler artikler fra en stor mengde medier, avdekker de mange varianter av samme sak:

Å samle visninger er en distraksjon for utviklere. Når annonsemodellen mister kraft, leder fokuset på sidevisninger til mindre verdier og minste felles multiplum-nyhetsinnhold. Det er på tide å se etter andre modeller.Frédéric Filloux

Du kan lese hele teksten hos Mondaynote.

Hvilket inntrykk sitter du igjen med etter mediedekningen av Tay?

Jeg mener vi daglig opplever dette i media, at hver og en artikkel er utformet kun for å generere trafikk. Alt i alt synes jeg Microsofts eksperiment var en suksess. Det samme skjer jo med barn i barnehage og på skole.

[…] Allen Institute er grunnlagt av Paul Allen, som også var med å grunnlegge Microsoft sammen med Bill Gates. Microsoft har selv vært borti noen uheldige opplevelser med AI-systemer, blant annet den rasistiske Twitter-boten Tay. […]