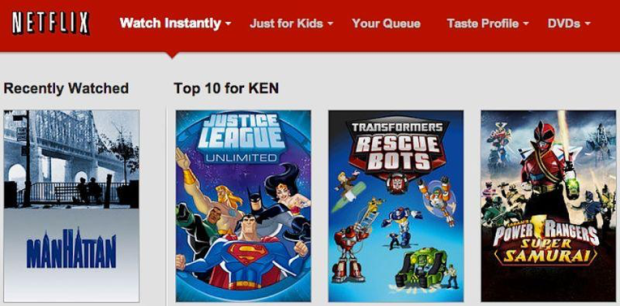

I løpet av de siste årene har flere hendelser synliggjort hvordan maskinlæringssystemer og algoritmer kan begå tabber med komiske og/eller fatale konsekvenser. Mange av oss har sikkert opplevd hvordan Netflix har sett sammenhenger i seervaner og innhold som ikke henger på greip:

Bildegjenkjenningen til Google Photos har klassifisert bilder av afroamerikanere som gorillaer. Under en gisseltagning i Sidney i 2014 økte Uber prisene sine kraftig som en konsekvens av den høye etterspørselen i området – helt etter algoritmeboka, men neppe en ønsket konsekvens.

Google Photos, y'all fucked up. My friend's not a gorilla. pic.twitter.com/SMkMCsNVX4

— Jacky Alciné (@jackyalcine) June 29, 2015

Her på South by Southwest-konferansen i Austin er det ingen mangel på nye teknologier eller idéer som skal redde eller snu opp ned på verden vi lever i: Virtual reality, flyvende biler og Hyperloops, kunstig intelligens og butler-roboter. Samtidig er det også en gryende tendens til teknologi-skepsis og økende bevissthet rundt de etiske problemstillingene som dukker opp når hele virkeligheten skal kvantifiseres og samles inn som datapunkter.

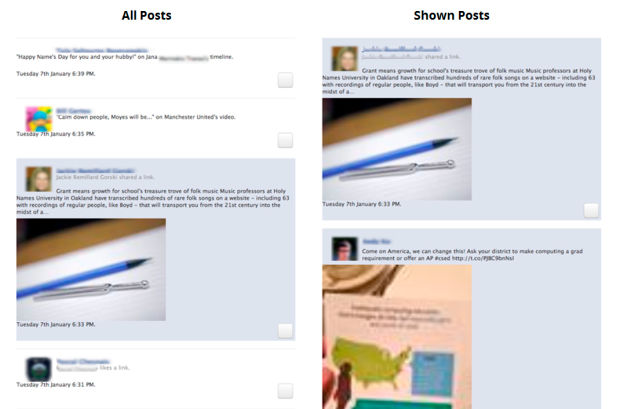

I en studie fra 2015 trodde 60% av deltakerne at Facebook-feeden var en enkel, kronologisk liste over ting vennene har postet og likt. De var ikke klar over at den er basert på en utstudert og kompleks algoritme-styrt filtrering

Christian Sandvig har forsket på hvordan publikum oppfatter og reagerer på tjenester som baserer seg på algoritmer. I en sesjon med tittelen «Algoritmisk vanvidd» hevder Sandvig at algoritmene er i ferd med å bli moderne myter; ugjennomtrengelige, uoppnåelige, og uforståelige. Siden vi som brukere ikke kjenner til mekanismene bak algoritmene, konstruerer vi «folkehistorier» og teorier om systemene vi bruker.

Algoritmiske misforståelser

Moderne digitale tjenester utformes ofte på en måte som skjuler detaljene og mekanismene bak systemet, for å oppnå et sømløst design. Et av Sandvigs forskningsprosjekter gikk ut på å tydeliggjøre «sømmene» bak systemet, og eksponere logikken bak algoritmene. Forskerne implementerte en versjon av Facebooks News Feed som faktisk var en kronologisk liste for brukeren, og markerte samtidig det innholdet Facebook-algoritmen hadde valgt å fremheve i tjenesten.

Deltagerne i studien ble bedt om å beskrive hvordan de trodde Facebook-algoritmen fungerte og hvorfor feeden var som den var. Respondentene hadd ulike og spredte teorier om disse mekanismene. Noen av dem bar preg av at vi har en tendens til å personifisere systemene vi bruker til daglig.

Mange beskriver Facebook-algoritmen som et slags altseende øye, som aldri fullt ut kan forstås eller kjennes.

Sammensetningen av Facebook-feeden er med på å forme oss og kulturen vi lever i, uten at vi kjenner til mekansimene bak algoritmene. Ifølge Sandvig er det ikke sikkert at Facebook har så god oversikt heller. Sandvig diskuterte ulike prinsipper for å designe algoritmestyrte systemer på en etisk forsvarlig måte, ved å gjøre «systemsømmene» synligere og gi større muligheter for brukeren til å overstyre eller deaktivere algoritmene.

Trenger vi en ed?

– «Vanlige» utviklere og designere blir bedt om å løse tekniske problemstillinger de ikke nødvendigvis ser konsekvensene av, eller er komfortable med å implementere. Hver gang gjennom historien hvor en yrkesgruppe har oppnådd slik uforholdsmessig makt, har man kommet frem til en kodeks som avgrenser og definerer hva som er «innenfor». Det har skjedd med leger, advokater og journalister. Trenger vi en slags «Hippokratisk ed» for utviklere? spør Microsoft-forskeren Kate Crawford i et panel på konferansen.

Facebookfeeden består i stor grad av matvideoer og bursdagshilsner. Om vi ikke nødvendigvis kan forklare hvorfor de dukker opp, er det kanskje ingen stor krise. Men hva om utfallet av algoritmen har større konsekvenser? Ifølge en artikkel i Ars Technica baserer NSA seg på maskinlæring for identifisering av mål for droneangrep. Og Facebook har patentert løsninger for å gi kredittvurdering basert på data de høster om deg på plattformen. Det er noe annet enn kattebilder.

I forutsigbar amerikansk stil er selv de største teknologiskeptikerne her i Austin preget av en dyp skepsis til lovgivning og statsregulering.

Men er en «dataetisk ed» noe bedre? Og isåfall; hva skulle det stått der?

En algoritme blir aldri bedre enn kunnskapene til den eller dem som utvikler den.

Alt for ofte kan man oppleve at software er utviklet av folk totalt blottet for erfaring innen emnet de lager «verktøy» for. Resultatet er desverre alt for ofte at ting går galt. Og så lenge ingen på beslutningsplanet blir stillt til ansvar, kommer dette til å fortsette.

Nooen ganger kunne slike feil blitt unngått ved at medarbeidere med erfaring fikk gjennomgå og teste produktene før de blir tilbudt vanlige brukere.

Selvsagt kan de det! Algoritmer som baserer seg på læring kan langt på vei overgå utviklerens kunnskaper. Foreløpig er dette begrenset til ganske snevre domener, for eksempel sjakk-verdenen eller et simulert miljø i et dataspill, men det er ikke usannsynlig at domeneskillene vil vaskes ut med tiden. Da sitter vi igjen med ASI og konsekvensene av det.

Jeg synes ikke IBM Watson arbeider innenfor et snevert domene. Den kan blant brukes til rådgivning i bedrifter og besvarelse av komplekse spørsmål. Se youtube.com/watch?v=_Xcmh1LQB9I

vi kan jo starte med robot-lovene.. 😛

orginal:

«A robot may not injure a human being or, through inaction, allow a human being to come to harm.

2.A robot must obey the orders given it by human beings except where such orders would conflict with the First Law.

3.A robot must protect its own existence as long as such protection does not conflict with the First or Second Laws.»

en.wikipedia.org/wiki/Three_Laws_of_Robotics

oppdatert versjon:

1: Jeg skal aldri utvikle automatiske maskiner eller systemer ment for å skade eller drepe mennesker eller dyr.

2: Alle maskiner jeg utvikler skal kontrolleres av minst 1 person.

3: Hvis jeg må lage ett våpen, så skal det kun brukes til forsvar av mennesker eller dyr, så fremt våpenet ikke strider mot lov 1 og 2.

Roboten kan omgå loven ved å lage to våpen.

hehe, en robot klarer ikke å lage ett våpen.

Den må bli kontrollert og få en kommando om å lage den.

Hvis jeg lager en fabrikk som produserer våpen automatisk, altså en robot som lager våpen, så er det jeg som lager alle våpnene og ikke fabrikken.

Samme kan du si om sex-dukker.

Hvis jeg lager en robot som kan tilfredsstille damer, så er det jeg personlig som tilfredsstiller alle som bruker den.

vi burde forandre regel 1 og legge til noen flere regler selvsagt.

for eksempel

1: hvis jeg må konstruere et verktøy for å forsvare, så må våpenet være i stand til å drepe maksimum 10 personer hver gang det aktiveres.

en person må aktivere våpenet og den kan ikke være styrt av miljøet eller tid.

du glemte nullte-loven…

det er jo her moroa med kjøttvekta begynner.

om bilen MÅ kjøre ned noen, skal den velge den gamle damen i gangfeltet, eller barnevogna?

blir det korrekt å ta livet av ti for å redde tusen?

Amnesty m/venner får bare be opp til fest snarest, for her er det mye å ta tak i…

Alt det kan man jo spørre seg selv om også da…=)

Hvis du måtte velge om å kjøre ned en barnevogn eller en gammel dame, hva ville du valgt?

Roboten din kommer til å velge det samme.

du tror altså at man har oversiktig over hva som skjer i disse algoritmene per i dag?

dvs. at given input x så vil det gi output y?

det vet man i praksis IKKE før man har forsøkt input x.

om du ser litt på hva gutta på google (brain) har holdt på med de siste åra, så har de blitt overrasket mang engang. joda, de har sett retningen til ville ta, men å nøyaktig forutse resultatene…

de har endt opp med å «konkludere» at «androids do dream about electric …» etc.

så nei, jeg vil ikke nødvendigvis kunne bestemme (som i forutse og justere) parametere eller resultat på det nivå når det kommer til slike etiske valg.

ifølge nullte-loven er det forbudt å lage biler som blir styrt av miljøet og bruke de i nærheten av mennesker fordi den kan komme til å skade menneskeheten eller passivt la oss gå til grunne.

*men bare hvis bilen «selv» må velge en som skal dø av 2 individer.

Dersom du leser Asimovs bøker (ja, mannen bak disse robotlovene), så ser hvordan robotene utvikler seg til stadig å tenke videre om hva det vil si at en menneske «kommer til skade». Etterhvert blir konklusjonen at man må tenke på hele menneskeheten (dvs. vi tenker oss her en meget avansert robot selvsagt). Og til slutt blir en konklusjon at robotenes tilstedeværelse passiviserer og skader menneskets utvikling – de må derfor trekke seg tilbake, og kontrollere menneskenes historie i fra et skjult sted.

For å si det sånn: det er nok av problemer å ta av….

Jeg tror han som laget disse lovene så verden fra verktøyenes side, som om de hadde fri vilje og kan utvikle seg på samme måte som evolusjon.

Med de oppdaterte robot-lovene trenger du ikke å være redd for sikkerheten til menneskene fordi det ville vært ulovlig å lage en maskin og programmere den til å lete etter og hente opp materialer fra bakken, smelte det om til brukbare robot-deler, finne nok energi, og lage kopier av seg selv.

Det de kaller for «AI», hvis roboten noen gang kan utgjøre en trussel for mennesker uten at du fjernstyrer den.

Hvis man er redd for å lage en ny dyre-art som kan utslette oss, så ville jeg vært mer redd for gen-manipulering.

Hva om noen gen-manipulerer gorialler til å bli like smarte som eller smatere enn mennesker?

Da er de sterkere Og smartere.

Asimov har vel uten tvil popularisert og (muligens for) enkelt fremstillt moralske og etiske, filosofiske, psykologiske, sosiologiske og økonomiske problemstillinger og dilemmaer i forbindelser med roboter og AI.

ja jeg har forlest meg på Asimov 😉

Er redd for at vi fort ender opp som blondinen som ønsker seg «fred og sånn». Men at etikk bør gis en sentral plass i all teknologisk undervisning, er innlysende. Etikk bør være en del av alle utdannede menneskers kompetanse. Etikk er et annet ord for empati og demokrati. Etikk === sivilisasjon.

[…] Research, har sagt at da profesjoner som leger og advokater fikk økt makt i samfunnet, ble det utviklet etiske regler de måtte følge. Tenk bare på den hippokratiske eden som nyutdannede leger avlegger. På musikk- og […]

[…] fikk oss til å spørre om det er på tide med en moralkodeks for digital produktutvikling, for å gjøre algoritmene mer transparente. Det er i dag umulig å vite hvordan eksempelvis […]

[…] På det tidspunktet er det viktig at vi har rigget oss riktig med både regler og etisk programmering av maskinene. […]

[…] har sagt at da profesjoner som leger og advokater fikk økt makt i samfunnet, ble det utviklet etiske regler de måtte følge. Tenk bare på den hippokratiske eden som nyutdannede leger avlegger. På musikk- og […]