Først litt bakgrunnshistorie:

Oppgaven var å lage en 20-30 sekunders promo for MGPjr. som fokuserte på forventing, artistdrømmer og musikkfesten i Spektrum.

Tidsfristen var kort og Margrethe Røed, programleder, var travel med forberedelser til den nært forestående direktesendingen. Ideen som vant «budrunden» var å la Margrethe ta veien artistene på MGPjr. går – de starter på gutte/jenterommet, øver, spiller inn, før de til slutt står på scenen i Spektrum.

For å gjøre denne reisen mer interessant visuelt, ønsket jeg å gjøre den i én tagning. Inspirasjon fant jeg blant annet i AB/CD/CDs video for Uffie – Difficult.

En slik visuell reise er ikke mulig uten å gjøre en skikkelig rekvisittjobb, og kanskje også bygge noe av scenografien som må til. Hverken budsjettet eller tilgjengelig tid tillot det.

Å flytte et filmteam mellom egnede steder er også kostbart og tidkrevende, så vi bestemte oss for å løse dette ved hjelp av grønnskjerm i et studio på NRK.

Dermed ble løsningen at vi filmet Margrethe gående på en tredemølle mot en grønnskjerm, og la inn rommene hun beveger seg gjennom i ettertid. Rommene skulle lages ved hjelp av photogrammetry.

Fredag 23. oktober var dato for opptaket. Første sending av ferdig promo var fredag 30. oktober.

Røde lamper blinker men ignoreres av undertegnede.

En kjapp advarsel før vi fortsetter: Denne artikkelen handler om postproduksjon og kommer til å ha temmelig høy teknisk vanskelighetsgrad innimellom. Den vil nok også ha et noe broket forhold til norsk språk, bare så det er sagt.

Trøbbel i kronologisk rekkefølge:

- Jeg tok ingen mål på settet – fredag 23. oktober

- Photogrammetry er vanskelige greier og vil ikke funke – tirsdag 27.okt

- Arbeidsstasjonen krasjer – onsdag 28. oktober

- 3D-render skal ta 300 timer når det er 48 timer til deadline – onsdag 28. oktober

- Jobben er gjort, men lar seg ikke eksportere – fredag 30. oktober

- 300 timers-render’n er egentlig ikke god nok.

Jeg tok ingen mål på settet

Jeg har vært med på nok postproduksjon til å vite at å ta noen enkle mål av distanser på settet er veldig bra å ha i ettertid. Disse målene kan fôres rett inn i 3d-programmene i ettertid og vips så har du korrekt skala på all 3d med en gang.

I kampens hete tenkte jeg «hvor vanskelig kan det være å anslå disse målene i etterkant?», og fokuserte på regijobben – som også var min.

Det viste seg at store deler av mandag 26. oktober skulle gå med til å få skalaen på dører og rom riktig, og ikke minst farten disse skulle bevege seg vekk fra kamera i. Hadde jeg tatt ett eneste mål mellom de to stativene Margrethe går mellom, ville lengdene vært gitt ut i fra det og hvor stor døra hun går gjennom skulle være.

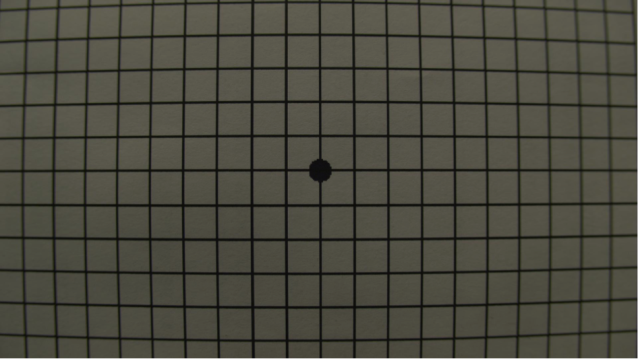

Et «mål» jeg heldigvis, klok av skade, tok med meg fra settet, var en lensgrid. Når man skal legge til 3d-elementer i et videobilde trenger man å vite hvor mye linsa forvrenger for å kunne smi 3d’en sammen med videoen på en troverdig måte.

Bildet av Margrethe må også «av-forvrenges» for å kunne få tracket kamerabevegelsene. Har man en slik referanse på forvrengning, kan man derfor «undistorte» videobildet for trackingens del, og forvrenge den ferdige 3d’en slik videobildet er forvrengt når man skal sette de sammen. Dette kalles «comping» – en prosess vi kommer tilbake til.

Photogrammetry er vanskelige greier og nekter å funke

Photogrammetry er en veldig fascinerende teknikk for å skape 3d-modeller av stillbilder, og terskelen for å gjøre det er utrolig lav.

Alt man trenger er et kamera, til og med mobilkamera vil fungere, og så finnes det både apper og programmer til å analysere bildene og gjenskape objektet eller omgivelsene du har tatt bilder av til en 3 dimensjonal modell, ferdig med teksturer. Mange slike apper og programmer er til og med gratis.

Så når jeg tok med meg 5d’en vår og skjøt i vei på Øvingshotellet og hos PhatCat Studios for å skape bakgrunner, forventet jeg lite motstand. Men der tok jeg feil. Resultatet jeg fikk igjen var hullete og lite komplett, i tillegg til å egentlig ikke ha den layout’en jeg trengte for at Margrethe naturlig skulle kunne gå fra rom til rom.

Jeg brukte Autodesk Memento til jobben, men bildene jeg hadde tatt var nok for dårlig lyssatt til at modellene ble brukelige.

Rent kronologisk har vi nå kommet til godt utpå dagen tirsdag, og deadline lusker i horisonten. Da er det bare en ting å ty til: Kommersielt produserte 3d-modeller.

Problemet er at de fleste slike modeller er laget for renderen V-ray, og den har ikke jeg i min arbeidsflyt. Modellene, eller snarere materialene, kan konverteres til renderen jeg bruker, Mental Ray, men det er tidkrevende og møysommelig arbeid med stor fare for å lage søl – fryktelig mye søl.

Videre var planen min å rendre på vår lokale renderfarm med programvaren Autodesk Backburner, og selv om Backburner er fantastisk fleksibel så vil den stoppe opp ved den minste feil i nevnte materialer eller teksturer.

Heldigvis så er det flere vrange Mental Ray brukere enn meg der ute, og med Thorsten Hartmann’s Shader Utilities var konverteringen gjort med ett klikk. Gratis. Det skulle jeg gjerne visst før jeg satte meg ned og brukte en hel formiddag på å manuelt konvertere ungdomsrommet.

Tidsnød lærer naken nørd å søke.

Med nød og neppe klarer jeg å sende av gårde en 420 ruters render til Backburner før jeg går hjem for dagen. Den skal i følge beregningene være ferdig i løpet av torsdagen, som fortsatt gir meg tid til å compe fredag, samme dag som deadline.

Onsdag: Arbeidsstasjonen krasjer

Jeg jobber ofte lokalt. Det er veldig dumt, men det går jo stort sett bra, ikke sant?

Faktisk har min HP z800 arbeidsstasjon ennå ikke tryna fatalt. Så den har min uforbeholdne tillit. Men nå, mens den rendrer en av årets viktigste jobber, så krasjer den 20 minutter etter at jeg via remote desktop sjekker den for siste gang og går og legger meg.

Så selv om Backburner jobber over nettverket og rendrer på flere PC’er som ikke har krasja, så er det ikke lenger noe sted å skrive ferdige renders til.

Vi er nå kommet til onsdag morgen, og selv om jeg restarter renderen vil den ikke være ferdig til tidsfristen. Stort problem.

Det viser seg at det er Google Drive som er synderen, som i bakgrunnen har fylt opp OS-disken min til bristepunktet, og med 3-4Mb med ledig plass har hele maskinen paja.

Rendre 300 timer med 3d når det er 48 timer til deadline

Renderfarmen, som jeg stort sett har haiet sammen selv, består av 4 dedikerte maskiner, min arbeidsstasjon, og 3 kontorlandskaps-PCer.

Autodesk 3ds Max tillater rendring på 9999 maskiner per lisens, så om du går fra PC’en din ulåst i nærheten av meg, vær forberedt på at den er blitt en del av renderfarmen når du returnerer (satt på spissen).

Men når rendertiden er ca 30 minutter per bilde og du har 420 bilder så blir regnestykket (30 X 420) / 7 maskiner = 56,25 timer med rendring, om alt går smertefritt.

Ting går sjelden smertefritt.

Eneste utvei blir da å rendre ute på byen, og valget faller da på Rebusfarm i Tyskland. De kan rendre jobben på 4 timer. Det gir plenty av tid til å compe.

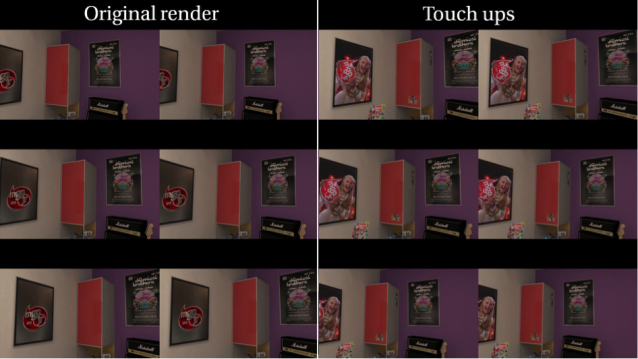

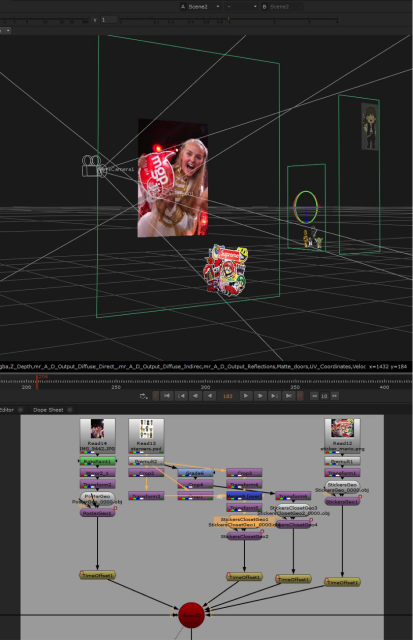

Men de skal selvfølgelig ha betalt, så å feile er ikke noe alternativ og jeg bruker resten av onsdagen på å forsikre meg om at 3d’en er helt feilfri. Jeg rendrer lavkvalitetsversjoner med 3ds Maxs «Grab viewport»-funksjonalitet og comper over Margrethe med Nuke Studio.

Til å se på resultatet bruker jeg den geniale (og gratis) djv_viewer.

Men så, helt på tampen av onsdagen, når jeg er klar til å sende av gårde den ferdige scenen, vil ikke Rebusfarm samarbeide. Scenen refereren til videoråmaterialet og feiler på grunn av dette. Denne feilen gir ingen mening for min del, da videomaterialet aldri er blitt lagt inn i 3ds Max av meg. Feilen må ha sneket seg inn via PFtrack, som jeg bruker til å tracke kameraet. PFtrack eksporterer et script som jeg kjører i 3ds Max, og denne filen må ha hatt referanser til alt råmaterialet.

Heldigvis har Rebusfarm telefonsupport, og selv om mannen i andre enden hadde liten erfaring med 3ds Max, anbefalte han meg å lage en ny scene og importere all geometrien fra den opprinnelige scenen. Som anbefalt så gjort, og vips var referansene til videomateriale borte og scenen lot seg oversende til Tyskland for rendring. Det mannen på support ikke nevnte (og som heller ikke var hans ansvar) var at alle renderinnstillingene mine nå forsvant, siden disse ikke blir importert.

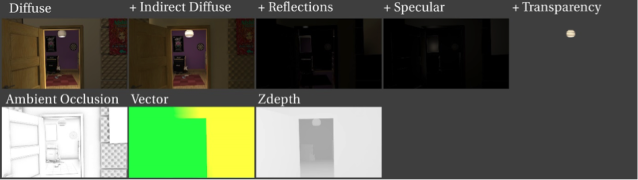

Jeg rendrer vanligvis med Diffuse, Indirect Diffuse, Reflections, Specular, og Transparency i separate pass, slik at jeg kan justere utseende på renderen med stor fleksibilitet i etterkant. I tillegg rendrer jeg Zdepth som gjør det mulig å endre linsefokus og Vector som kan lage motionblur.

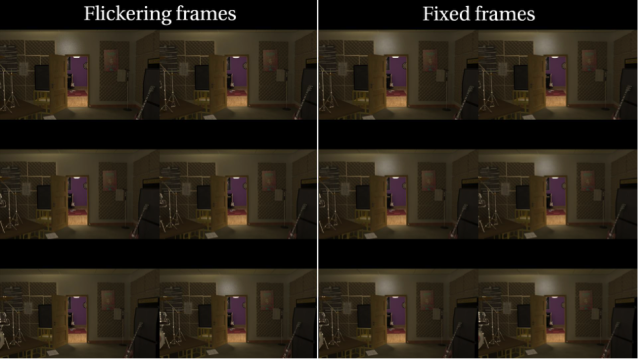

Ved ankomst på jobb torsdag morgen innså jeg feilen, da jeg så gjennom filene jeg mottok fra Tyskland. Alt jeg fikk var selve hovedpasset, eller beauty’en som den kalles, i 16bits tifformat.

Vanligvis rendrer jeg til 32bits EXR.

Siden flere av lysene i scenen min hadde altfor høye innstillinger, var nå flere av høylysene blåst helt ut, og jeg fikk hakkete overganger i forløpningene mellom lys og skygge. Slike feil er langt mindre problematiske i 32bit, siden man her kan ha langt høyere (og lavere) verdier enn i 16bit. Ikke hadde jeg fått Zdepth eller Vector heller.

Hva gjør vi nå? Renderen får til nøds gå på lufta som den er, men jeg trenger Zdepth og Vector. Løsningen blir å sende i vei en ny render på den lokale farmen, men denne gangen med 3ds Maxs scanline renderer i stedet. Denne rendrer mye mindre realistisk enn Mental Ray gjør, men også raskere. Spørsmålet er bare om den klarer det raskt nok? Realismen er uinteressant siden det er bare de tekniske passene jeg er interessert i.

Fredag: Jobben er gjort, men lar seg ikke eksportere

Compingen gjøres i Nuke Studio, et beist av et program. Alt dette beistet kan gjøre av magiske triks er nesten ikke til å begripe, men det er også en smule humørssjukt og krasjer med den største glede – særlig om det må lese filer det ikke liker. Nuke Studio hadde samme syn som meg på min 16 bits tiffer; ikke imponert.

Torsdagen gikk dermed til å krangle seg gjennom compejobben. Video-filene med Margrethe var av perfekt kvalitet, så keyingen, operasjonen hvor man fjerner grønnveggen, gikk med ett klikk ved hjelp av Nukes IBK-keyer. Nuke har også en udødelig auto-lagringsfunksjon, så selv om jeg krasjet opptil 20 ganger i løpet av torsdagen, mistet jeg ikke ett klikk arbeid.

Fredagen var nå ankommet og jobben skal eksporteres fra NukeStudio og til publisering. Backburner Scanline-renderen gjør seg også ferdig i løpet av dagen, så jeg får lagt på motion blur og riktig fokus på 3d-bakgrunnen.

Men å eksportere skal vise seg å bli veldig vanskelig. Nuke gir nemlig bare fra seg den noe uspesifikke feilen «exit code 1» og lar meg ikke eksportere noen verdens ting. Tålegrensa for tekniske problemer begynner nå mildt sagt å nærme seg. Jeg er ikke den eneste i verden som sliter med denne feilmeldingen viser det seg når jeg googler, men løsningen er det ingen som har.

Nuke Studio er en videreutvikling av forgjengeren Nuke, og brakte enkle redigeringsfunksjoner på banen. Compingen foregår fortsatt i Nuke, men Nuke Studio har en frameserver som rendrer compingen i en fart man bare kan drømme om i Nuke. En mulighet er derfor å rendre inne i Nuke på gamlemåten med en langsom write-node, men Nuke Studio har allerede rendret compen til dpx filer som brukes til playback. Eksportere de derimot får jeg ikke lov til.

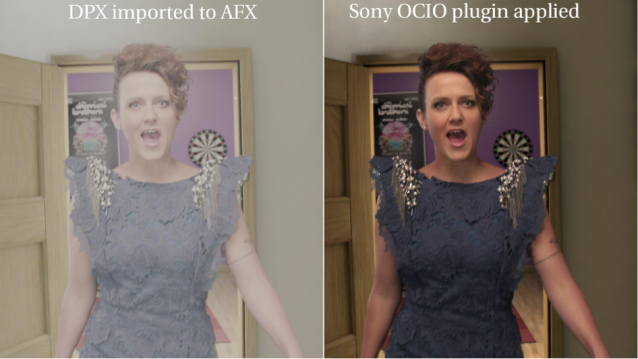

Men hei, Premiere, som jeg uansett skal bruke til å publisere den ferdige promoen, leser dpx – problem løst! – tenker jeg. Men den gang ei. Tar man inn DPX i Premiere kommer den med et utseende som yter compen fra Nuke svært lite rettferdighet. Det samme gjelder After Effects. Uansett hva slags innstillinger jeg forsøker, er et utvasket, desaturert bilde resultatet.

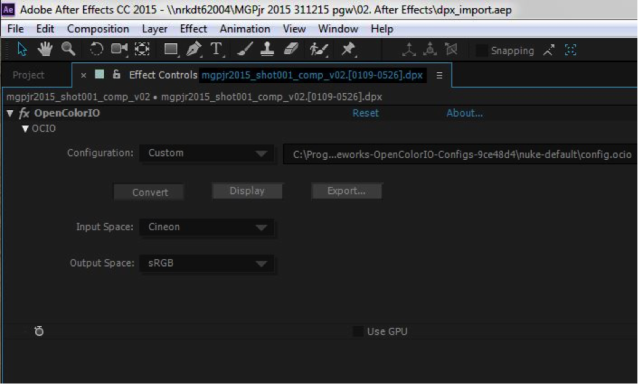

Med en fullstendig tynnslitt tålmodighet tyr jeg igjen til internettet, og søkeresultatet denne gangen viser seg heldigvis å være av det svært relevante slaget. Sony har en åpen fargebehandlingsstandard kalt OCIO, og med den en After Effects plugin som lar deg spesifiere inngangs- og utgangsbehandling av videofilene. Gratis. Hurra!

Så i siste liten går promoen på lufta, selv om det er en ganske sliten og ikke helt fornøyd regissør/redigerer/trackeartist/3d-artist/render-tekniker/it-tekniker som går hjem den fredagen.

300 timers-render’n er egentlig ikke god nok.

Det plager meg nemlig at renderen fra Tyskland var så dårlig som den var. Mye ville løst seg om jeg bare fikk rendret ut i 32 bit, og beholdt passene mine. Så via remote desktop starter jeg en ny Backburner-render på den lokale farmen, som får stå og koke gjennom helgen.

På mandag, 6 dager før MGPjr. går av stabelen har jeg omsider en 32bits exr sekvens med alle ønskelige pass, som Nuke freser gjennom som corn flakes. Men jeg er egentlig ikke helt fornøyd hvordan den ser ut rent innholdsmessig, plakaten som starter hele kalaset er litt for intetsigende, og rommet er generelt litt døllt. Renderen fra Max tar som kjent lang tid, så skal det fikses må det gjøres på en rask måte.

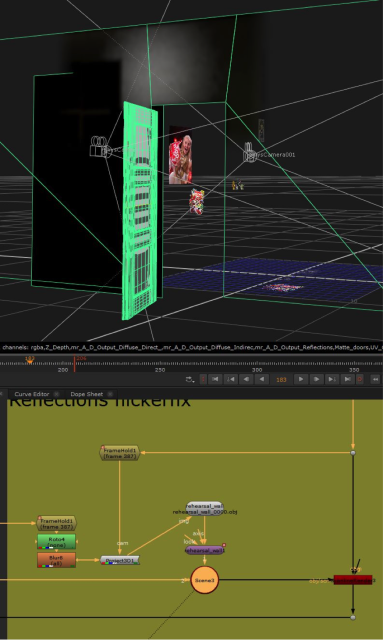

Nuke har også en egen 3d-scanline render. Og ved hjelp av en helt genial (og gratis) plugin til 3ds Max kalt Nuke’m, kan du lime inn, jeg gjentar, LIME INN, kameradata og 3d-geometri fra Max inn i Nuke.

Derfor kunne jeg oppdatere enkle detaljer som f.eks posteren uten å måtte rendre hele rommet på nytt i Max. Jeg fant et bilde fra fjorårets MGPjr. som jeg følte ga mer liv som en poster, og noen klistremerker til vegger og skap, satte disse opp i 3ds max og overførte oppdateringene til Nuke-rendrer’n.

Siden renderingen min nå er delt opp i pass kan jeg enkelt sette opp en scanlinerender i Nuke til å rendre over Diffuse+Indirect-passet mitt, og så plusse refleksjoner og høylys oppå der igjen. Og vips så er en render som tok 30 minutter oppdatert på sekunder.

Den nye EXR-renderen min hadde dessverre fortsatt en teknisk feil, nemlig at noen av refleksjonene flimret i det midterste rommet.

Men igjen var det Nuke’m som reddet meg: jeg eksporterte geometrien med den flimrende refleksjonen til Nuke, fant en ramme som ikke flimret, prosjiserte (ved hjelp av Project3d-noden) denne på geometrien og la så denne over det flimrende passet. Noe ytterligere geometri (som dører) ble eksportert og brukt som masker (ved å bruke fillMat-noden som materiale) etter hvert som de oppdaterte bitene forsvant bak disse objektene. Ingen av disse fiksene ville fungert uten at jeg hadde rendret i pass.

Så, omsider, på tirsdag morgen, går en versjon jeg er fornøyd med på lufta.

Og om du har hengt på helt hit, vil jeg bare få takke for oppmerksomheten, og si at jeg håper du har lært litt om postproduksjon og hvor knotete det kan være. Særlig når tiden er knapp og viktige detaljer oversees.

Denne artikkelen er skrevet av Pål Gustav Widerberg som jobber som regissør/redigerer/trackeartist/3d-artist/render-tekniker/it-tekniker i NRKs markedsavdeling.

Klippeverktøy: Premiere Pro cc2015

Tracking: PFtrack 2015

3d-modeling/rendering: 3ds Max med mental ray and Backburner

3ds max plugins: Nuke’n 2.9.4 og Shader Utilities Pro

Compositing: NukeStudio v9.08

Regi og VFX: Pål Gustav Widerberg

Foto: Martin Edelsten

Lys: Ole Bernt Helgås

Som tidligere 3D og animasjons-student på NKH og VFX-interessert, så føler jeg stresset ditt. Godt jobbet. Og veldig interessant å lese om hvordan 3D, VFX og post-prod skjer på NRK. Skulle gjerne lest mer.

Hvorfor bruke så mye ekstra tid på lage et 3D rom, skyte på greenscreen for så å compose det sammen å få et rart resultat som ikke ser autentisk ut over hodet? Bra jobbet av han som har gjort 3D arbeidet, men man vil jo aldri få det så bra som når man filmer i et ekte rom. Med tanke på at det ikke var et vanskelig skudd å gjenskape i virkeligheten var det mye ekstra for noe som gir et dårligere sluttresultat. Tviler veldig sterkt på at det var billigere å gjøre den løsningen dere valgte kontra å leie en steady operatør, få lånt et rom med en gang og litt musikkutstyr.

Min erfaring er at å dresse slike lokasjoner som de vi trengte her, er en ganske mye større jobb enn man antar. Vi var ute og så etter ungdomsrom og studioer, men ungdomsrommene var for små og studioene for mørke – problemet da var å få plass til alt lyset vi trengte uten at det syntes for kameraet.

Neste problem var at ingen av studioene jeg besøkte i Oslo hadde en dør inn til miksebordet slik at Margrethe rakk å komme seg gjennom døra og frem til noe relevant og gjenkjennelig utstyr.

Siden ønsket var å gjøre reisen fra rom til studio uten klipp ble konklusjonen at vi ikke ville klare å skyte dette på location.

Hvor er (hjerte)-knappen på dette innlegget?

Hei Pål Gustav:-)

Høres ut som om du har mye av den samme utfordringene vi i MGPjr redaksjonen har for i det hele tatt få til dette prosjektet.

Takk for super innsats og godt jobba. Dette var interessant å lese om.

K sjefen har på NRKj sitt årsmøte skrytt uhemmet av oss og politikerne som var på besøk har løftet fram MGPjr som det prosjektet som gjør at vi må verne om lisensen.

Kanskje får du litt mer penger neste gang?

Jeg føler med deg! Hekkans krøkkete 3D når tiden er knapp er ikke gøy!

En løsning hvor kanskje bare scenen til slutt var 3D ville kanskje vært enklere og billigere? Med scene-teppe som skjulte overgangen..?

Litt irriterende food for thought fra meg sett i bakklokskapens lys.. 🙂

All inn all… Godt kjempet! Mang en regissør/redigerer/trackeartist/3d-artist/render-tekniker/it-tekniker ville gitt opp lenge før!

Mvh

Daniel French

Takk for medlidenheten!

Ja, skulle egentlig ønske at vi hadde gjort scenen i 3d, da vi kanskje kunne klart å gjøre den mer lik slik den så ut på sending i spektrum. Men det er egentlig ingen spøk å få et slikt shot til heller, med tanke på alt lys og remedier som måtte inn i en slik 3d-modell. Og mesteparten hadde jeg sikkert måtte modellere selv siden scenografien lages spesifikt til showet.

Videre fant vi ikke (på den korte tiden vi hadde til rådighet) noen gode locations for verken ungdomsrom eller studio – men de finnes sikkert der ute.

Utruleg kjekt å lese om koss slikt som dette blir gjort i NRK. Spesielt motiverande å få vite at de óg sitt og søkar på nettet rundt kvar ein sving. Forstår ærleg talt ikkje koss noko VFX-arbeid ble gjort i det heile tatt før nettsøk ble så bra som det er no.

Hadde ei professor i England som fortalte om i «gamle dagar» (på 80/90-talet) når VFX-artistar i London møttes ein gong i måneden for å diskutere problem og tips rundt Softimage. Utanom å ringe kontora til Softimage så var det den einaste praktiske måten å troubleshoote på.

Hei, Norskus! #twitterhighfive

Ja, nettet er virkelig en uvurderlig ressurs, spesielt i situasjoner som denne hvor tiden til å prøve og feil ikke eksisterer. Så både tips fra andre brukere på forum, og ikke minst alle gratis verktøy som entusiaster legger ut er jeg evig takknemlig for at finnes.

Morsom historie om professoren i England du forteller, jeg har en lignende selv, fra en mine lærere da jeg studerte i England: han jobbet i designavdelingen i BBC på 70-tallet, og da var en av de viktigste kvalifikasjonene man kunne ha å kunne klippe i farget papp i en forferdelig fart – det var slik de laget kart til nyhetssendingene…

Nor kan man melde på seg mgpjr 2016?

Beklager, men det ser virkelig ikke bra ut.

Det er veldig tydlig at du har bare tatt ned «Brightness» når henne skal gå fra rom til rom. Dette kunne løses lett ved å bare dimmet en lampe når dere filmet henne på greenscreenen.

Det er temmelig riktig beskrevet ja, i det hun går gjennom dørene multipliseres fargeverdiene med 0.27, som gjør de lysere verdiene vesentlig mørkere, mens de mørke verdiene ikke påvirkes i så stor grad.

Det kunne vært gjort på settet, men legg merke til at vi hvertfall har å dimmet lyset opp når hun går under lampene 😉

Bra jobba. Samtidig kunne jeg gjort det bedre selv med kun MAX 16-bit render og AE.

Det store problemet her er dørene. Alt ser CGI ut, men dørene skiller seg ut. V-Ray med GI ville gjort alt bedre. Men dørene…de mangler DOF og lyden er «rar»… 😛

Ja, dørene, særlig den siste er definitivt det svakeste leddet. Døra inn i studioet er for det første urealistisk bred, og har for få geometriske detaljer. Kunne vært forbedret med enkle grep som for eksempel lister og noe teksturer i overflatene.

Kombinasjonen Backburner+deadline+nattarbeid har tatt altfor mange år av mitt liv! Bra løst, tid og ressurser tatt i betraktning. Er generelt motstander av greenscreen på små produksjoner. Man skal ha veldig gode grunner for å erstatte virkeligheten med greenscreen fordi det krever så mye for å få det til å se rett ut. Et produksjonsteam på 5-10 personer med tid en ting, når du er en person som har ansvaret for hele kjeden med så kort deadline gjør du det ikke lett for deg selv! om du ikke har en utprøvd arbeidsflyt du har gjort mange ganger før!

Takk for ros! Ja, det er vanskelig å legge hodet helt ned på puta når man har en backburner render gående 🙂

Jeg skjønner motforestillingene dine mot grønnskjerm, det er fryktelig mye som kan gå galt og resultatet er sjelden 100% realistisk. Har man jobbet med slike ting i noen år skal det ganske lite til før man legger merke til dårligere-enn-perfekte shots på TV og film.

Når det er sagt, så liker jeg egentlig CGI best når det fungerer litt som en illustrasjon, slik som her. Jeg har ikke kompetansen til å få det til å se helt fotorealistisk ut, men visjonen var heller ikke at det skulle se helt ekte ut (så kan kan stille spørsmålet om hva som kom først av høna eller egget). Margrethe forteller en fortettet og dermed urealistisk fortelling i manus, så hvorfor ikke gi det visuelle et stilisert uttrykk også?

Jeg har gjort noen jobber tidligere i samme «ånd» om du vil – så det er vel en slags preferanse jeg har – både P3-aksjonen for amnesty – youtube.com/watch?v=JY4fR6XMC_g og Arctic Challenge youtube.com/watch?v=ktejPkQATno faller vel inn i kategorien «urealistisk realisme laget med korte tidsfrister av en fyr». Hvor jeg altså trives 🙂

Så med det sier jeg takk for alle tilbakemeldinger og engasjement som folk har vist her, det har vært lærerikt!